AI芯片是AI服务器算力的核心组成,随着AI算力规模的快速增长将催生更大的AI芯片需求。根据行行查数据,预计2022年中国人工智能芯片市场规模为850 亿元,2023年中国人工智能芯片市场规模将达到1039 亿元,2025 年中国人工智能芯片市场规模将达到1780亿元。

AI芯片行业概览

AI芯片即人工智能芯片,也被称为AI加速器或计算卡,是专门针对人工智能领域设计的芯片,其架构和指令集针对人工智能领域中的各类算法和应用作了专门优化,可高效支持视觉、语音、自然语言处理和传统机器学习等智能处理任务。

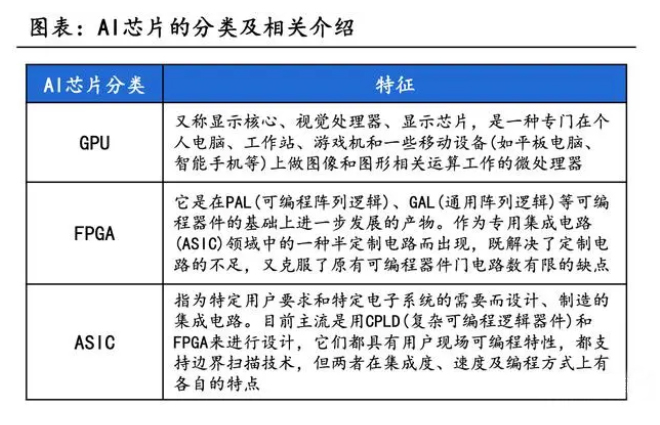

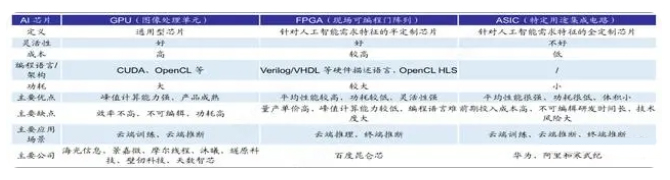

从技术架构来看,Al芯片主要分为GPU(图形处理器)、FPGA(现场可编程逻辑门阵列)、ASIC(专用集成电路)三大类。

其中,GPU是较为成熟的通用型人工智能芯片,FPGA和ASIC则是针对人工智能需求特征的半定制和全定制芯片。

GPU

GPU是图形处理器的简称,它是一种专门用于处理图形、视频、游戏等高性能计算的硬件设备。

GPU相对于传统的中央处理器(CPU)而言,其拥有更多的计算核心和更快的内存带宽,能够大幅度提高计算效率和图形渲染速度。

现阶段,随着例如英伟达A100、H100等型号产品的发布,GPU在算力方面的优势相较于其他硬件具有较大优势,GPU的工作也从一开始的图形处理逐步转化为计算。

GPU由于其具有最强的计算能力同时具备深度学习等能力,成为最适合支撑人工智能训练和学习的硬件,目前成为服务器中加速芯片的首选。

根据用途和性能表现,GPU可以分为专业卡和消费级卡两类:专业卡通常用于工程、科学、医学等领域的高性能计算和大规模数据处理,主要厂商包括英伟达、AMD等;消费级卡则主要用于普通家庭和游戏玩家,主要厂商包括英伟达、AMD、英特尔等。

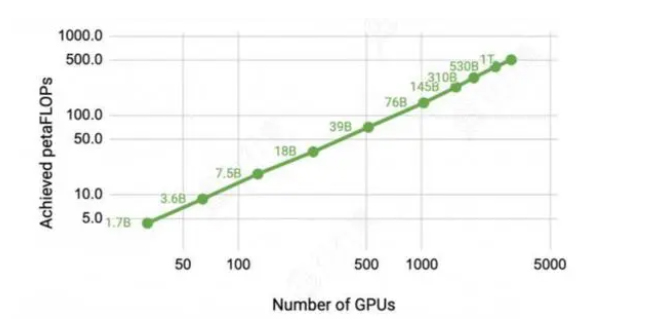

GPU数量和总算力的关系(GPU为英伟达A100):

2022年8月31日,英伟达、AMD生产的GPU产品被美国列入限制范围,英伟达被限制的产品包括A100和H100,AMD受管制GPU产品包括MI100和MI200系列。海光DCU属于GPGPU的一种,在典型应用场景下,海光深算一号指标达到国际上同类型高端产品的水平,在海外监管趋严的背景下,以海光为代表的国产GPU厂商迎来黄金发展期。

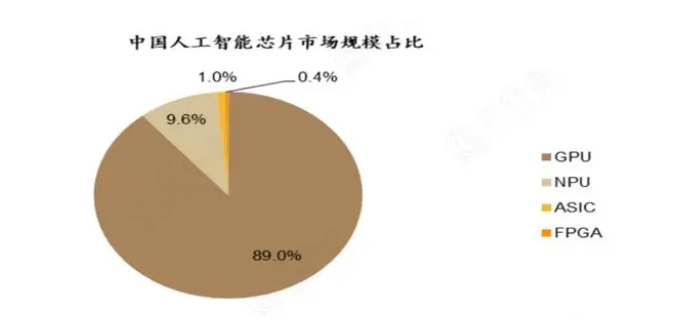

AI芯片以GPU为主,占总市场规模约九成:

2022年8月31日,英伟达、AMD生产的GPU产品被美国列入限制范围,英伟达被限制的产品包括A100和H100,AMD受管制GPU产品包括MI100和MI200系列。海光DCU属于GPGPU的一种,在典型应用场景下,海光深算一号指标达到国际上同类型高端产品的水平,在海外监管趋严的背景下,以海光为代表的国产GPU厂商迎来黄金发展期。

AI芯片以GPU为主,占总市场规模约九成:

FPGA

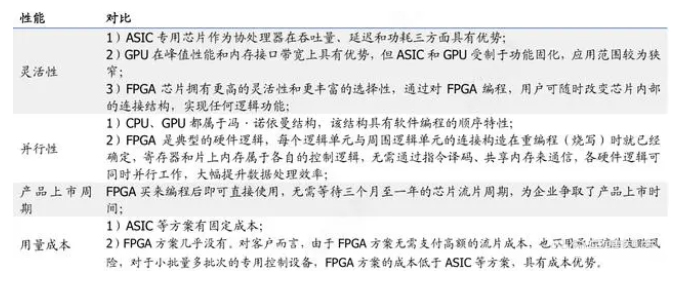

FPGA在灵活性等方面拥有ASIC、GPU等处理器无法比拟的优势。

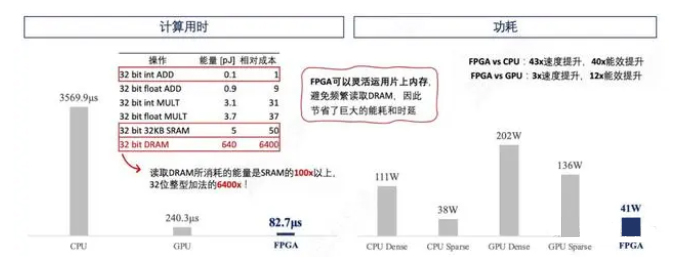

FPGA完全可以不需要读DRAM,整个算法在片上完成。例如,深鉴科技利用FPGA做出了ESE的模型并在不同的处理器(CPU/GPU/FPGA)上运行,发现FPGA上训练时长最短,能耗最小。

在能耗上,CPU Dense耗能11W、CPU Sparse耗能38W、GPU Dense耗能202W,这是耗能最大的一种情况、GPU Spare耗能136W,相比之下FPGA仅需41W;在训练时延上,FPGA用时82.7μs,远小于CPU的6017.3μs,也仅为GPU训练时长的三分之一。

资料来源:ESE

FPGA不仅拥有软件可编程性和灵活性,还兼具硬件的并行性和低延迟性,在上市周期、成本上具有很大的优势。

因此在人工智能、5G通信等迭代升级频繁的领域,FPGA成为比较理想的解决方案。

行行查 | 行业研究数据库 资料显示,FPGA产业链较为复杂,FPGA制造商对上下游企业议价能力较强。FPGA产业包括底层算法设计企业、晶圆代工厂、专用材料及设备供应商等上游企业,FPGA芯片制造商、封测厂商等中游企业以及视觉工业厂商、汽车厂商、通信服务供应商、云端数据中心等下游企业。整条产业链较为复杂,IBM、台积电、Intel、华为、腾讯等国内外知名企业均参与其中。其中产业链中游龙头FPGA企业在全球市场占据垄断地位,且对上游软硬件供应商和下游客户企业议价能力较强。

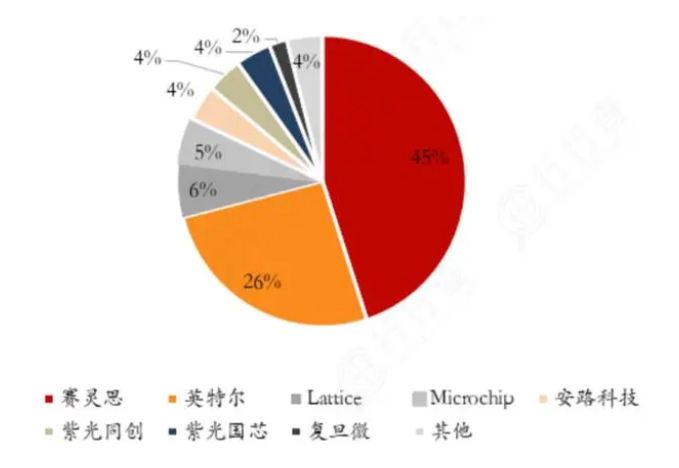

从市场格局来看,全球FPGA市场主要被赛灵思和Altera占据,目前市占率分别为52%和35%;其次为Lattice和Microsemi,份额均为5%。中国FPGA厂商中紫光国微、复旦微电和安路科技在2021年市占率超过15%。受益于国产化加速推进,中国FPGA厂商将拥有巨大成长空间。

ASIC

如果说在芯片产业上ARM对X86架构的反击制衡成就于移动终端的兴起,那么AI浪潮之下,AI芯片尤其是专用于深度学习的ASIC,用以点及面的方式实现跨越式发展,未尝不是一个弯道超车的好机会。

竞争空间上,传统的CPU领域有Intel、高通,GPU领域有英伟达,FPGA中有Xilinx和Altera,唯有与AI计算最为定制化结合的ASIC领域尚未有绝对的垄断性龙头。

应用场景上,智能手机、可穿戴设备、安防前端等均可能成为ASIC芯片落地放量的先行地。

AI芯片尤其是ASIC芯片由于其低功耗高效率的特点特别适用于功耗较低,空间较小的智能手机、智能安防摄像头、智能家居、无人机等智能终端,这些领域可能成为ASIC芯片率先放量之处。

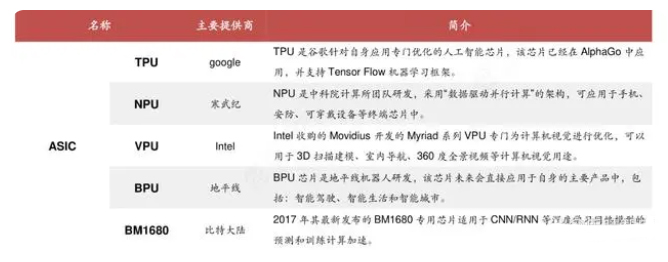

目前市场上主流ASIC有TPU芯片、NPU芯片、VPU芯片以及BPU芯片,它们分别是由Google、寒武纪、Intel以及地平线设计生产。

由于ASIC开发周期长,仅有大厂有资金与实力进行研发。同时,ASIC是全定制芯片,在某些特定场景下运行效率最高,故某些场景下游市场空间足够大时,量产ASIC芯片可以实现丰厚的利润。

ASIC市场格局及代表厂商:

资料来源:公开资料整理

AI芯片市场格局

据Liftr Insights 数据,目前在AI技术进展最为前沿的北美数据中心AI芯片市场,英伟达市场份额占比超过80%,且在训练、推理环节均保持持续领先;在数据中心AI加速市场,2022年英伟达市场份额达82%,AWS和Xilinx分别占比8%、4%,AMD、Intel、Google均占比2%。

国内AI芯片以寒武纪思元系列、华为昇腾系列等为代表,寒武纪和华为昇腾部分AI芯片产品性能已达到较高水平,有望加速实现国产替代,迎来高速发展期。

中国本土AI芯片厂商:

资料来源:广发证券

AI浪潮下,云计算、智能汽车、智能机器人等人工智能产业快速发展,市场对AI芯片的需求不断增加,AI芯片市场规模将持续增长。

郑重声明:文中仅代表作者观点,不代表本公司观点,本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时间联系我们修改或者删除,感谢您的关注!